Kompetenzerwartung: Verständnis für den Unterschied zwischen MIDI und Audio

Lerninhalt: Fachbegriffe rund um Midi und Audio in einer DAW (Digital Audio Workstation)

Voraussetzungen: keine

Anmerkungen: Einheit im Rahmen einer Multimedia-Einführung

MIDI und Audio

Download: Unterrichtseinheit als PDF-Datei

Was ist MIDI?

MIDI ist die Abkürzung für Musical Instrument Digital Interface und bezeichnet eine Hardware-Schnittstelle, ein binäres Speicherformat sowie ein Protokoll, das Steuerinformationen enthält, die es elektronischen Geräten wie beispielsweise Keyboards, Synthesizern und virtuellen Instrumenten ermöglicht, zusammen zu arbeiten. Da technische Definitionen leider meist abstrakt sind, soll ein Beispiel den Sachverhalt veranschaulichen:

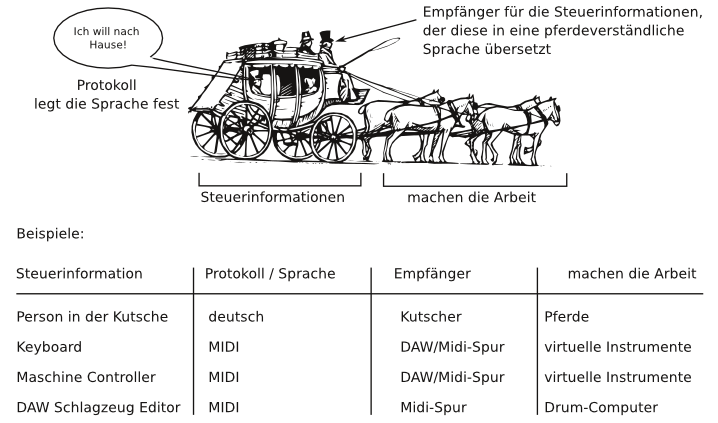

Stell dir Midi wie eine Kutsche vor. Würdest du in einer Kutsche sitzen und irgendwo hin fahren wollen, wären dies im übertragenen Sinn Steuerinformationen. Doch diese Steuerinformationen könnten nichts bewirken, wenn z.B. ein Kutscher fehlt oder keine Pferde da wären. Und deine Steuerinformationen würden auch nichts bewirken, wenn du nur Deutsch könntest, der Kutscher hingegen nur Chinesisch verstehen würde. Ein Protokoll könnte nun festlegen, in welcher Sprache du mit dem Kutscher reden müsstest, damit er dich versteht. Der Kutscher wiederum kann deine Befehle nur dann umsetzen, wenn Pferde vor die Kutsche gespannt sind, die seine Befehle ausführen können. Aus diesem Bild lassen sich alle Informationen entnehmen, um Midi zu verstehen.

Ein Midi-Signal kann beispielsweise aus den Anweisungen Note an/aus (Note On/Off), Tonhöhe C3 und Anschlagstärke 75 (Velocity) bestehen. Midi-Signale verfügen dabei über 128 Werte, d.h. Befehle können Werte aus dem Bereich zwischen 0 und 127 annehmen. MIDI-Dateien (mit der File-Extension *.mid) können darüber hinaus zahlreiche Spuren enthalten, wobei durch den geringen Speicherbedarf der Midi-Austausch zwischen Geräten bzw. Programmen sehr einfach ist. Die Eingabe von Midi-Informationen erfolgt über einen sog. Controller (z.B. ein Midi-Keyboard), die Midi-Ausgabe über ein sog. Instrument (Hardware- oder virtuelles Instrument).

Was ist Audio?

Beim Thema Audio wird zwischen analogen und digitalen Tonsignalen unterschieden. Ein analoges Tonsignal besteht aus Schallwellen bzw. Schwingungen, die wir hören und manchmal auch sehen können (z.B. an den Saiten eines Instruments oder an Lautsprechermembranen). In der Luft lassen sich Schallwellen als Folge von Druckänderungen vorstellen (Verdichtung-Verdünnung), die der Mensch in einem bestimmten Bereich (16 und 20.000 Hz) wahrnehmen und in neuronale Impulse umwandeln kann. Analoge Musik kann z.B. auf Schallplatten gespeichert, über einen Tonabnehmer in ein elektrisches Signal verwandelt, über einen Verstärker verstärkt und über Lautsprechermembranen wieder in Schalldruck umgewandelt werden.

Analoge Tonsignale werden zur Verarbeitung heute meist in digitale Tonsignale umgewandelt (analog → digital = A/D-Wandlung). Dazu werden analoge Signale gerastert und letztendlich über einen Encoder als lange Kette in binäre Zahlen übersetzt. Solche aus Zahlen bestehende Objekte werden auch als BLOBs (Binary Large Objects) bezeichnet. Um eine binäre Zeichenfolge wieder in ein Audioformat zurück zu verwandeln (bzw. zu dekodieren), wird ein Decoder benötigt, der zu dem Encoder ›passt‹, mit dem die Audiodatei ursprünglich in die binäre Zeichenkette kodiert worden ist. Encoder und Decoder bilden einen sogenannten Codec. Bei Audioformatem wird zwischen verlustfreien und verlustbehafteten Formaten unterschieden. Ein verlustfreies Format ist beispielsweise WAV-Format, ein verlustbehaftetes MP3-Format.

Fachjargon

Bei einer AD-Umwandlung werden also analoge Signale (mehrere tausend Mal in der Sekunde) von dem A/D-Wandler abgetastet und in eine binäre Zahlenkombination gespeichert (jeder Speichervorgang eines akustischen Ereignisses heißt Sample). Die Anzahl der Samples pro Sekunde wird dabei als Samplingrate bezeichnet. Je höher also die Samplingrate ist, desto feiner ist die Abtastung des analogen Signals. Beim Abspielen eines Audio-Files dreht sich dieser Prozess um: Alle Samples werden über einen D/A-Wandler (digital -> analog = D/A-Wandlung) transformiert und über einen Line-out-Ausgang als analoges Signal ausgegeben (also zuerst als elektrisches Signal, das dann verstärkt über Lautsprechermembranen in Schalldruckwellen umgewandelt wird). Abtastraten werden pro Sekunde gemessen: 1 Hertz ist eine Abtastung pro Sekunde. Die Radioqualität liegt bei ungefähr 22.000 Hz (also 22.000 Abtastungen pro Sekunde), für eine CD-Qualität werden 44.100 Hz benötigt und in Studioqualität wird sogar mit 96.000 Hz gearbeitet.

Wozu brauche ich das Wissen?

Wenn du in einer DAW (= Digital Audio Workstation) arbeitest, benötigst du dieses Wissen andauernd. Legst du zum Beispiel eine MIDI-Spur an, weißt du natürlich, dass du noch ein Instrument benötigst, um überhaupt etwas hören zu können. Oder für den Fall, dass du eine Audiospur anlegst, weißt du, dass du mit unkomprimierten Audiofiles arbeiten musst. Und dass du gleich zum Beginn für dein ganzes Projekt eine Samplingrate (bzw. Samplerate) angeben solltest, müsste dir auch klar sein, oder?